image

Kompletny przewodnik: Jak skonfigurować dostęp do Kimi K2.5 w Visual Studio Code z pluginem Roo Code

Wstęp: Rewolucja AI w edytorze kodu

W erze szybko rozwijającej się sztucznej inteligencji, programiści zyskują potężne narzędzia, które nie tylko przyspieszają kodowanie, ale także rewolucjonizują sposób, w jaki myślimy o tworzeniu oprogramowania. Jednym z najbardziej obiecujących modeli jest Kimi K2.5 chiński model językowy, który zdobywa uznanie wśród developerów na całym świecie. W tym artykule przeprowadzimy Cię przez proces konfiguracji Kimi K2.5 w Visual Studio Code, wykorzystując plugin Roo Code (fork od Cline ale Rooo Code jako jedyny jest wspierany przez Moonshot AI)

Historia AI i jej wpływ na programowanie

Integracja sztucznej inteligencji z edytorami kodu to przełomowe zjawisko, które można śledzić od początku XXI wieku. Początkowo AI była stosowana głównie do analizy danych i generowania raportów, ale z upływem czasu jej rola w tworzeniu oprogramowania stała się nieodłączna. Modele takie jak GitHub Copilot (2018), który pozwalał na autorytatywną sugestię kodu, czy Anthropic Claude (2023) model dedykowany programowaniu otwierały nowe możliwości dla developerów. Kimi K2.5, opracowany przez chińską firmę Moonshot AI w 2024 roku, reprezentuje kolejny krok w tej drodze, oferując unikalne funkcje, które łączą zaawansowane analizy kodu z wsparciem dla obrazów i ogromnym oknem kontekstowym.

Czym jest Kimi K2.5?

Kimi K2.5 to zaawansowany model językowy opracowany przez chińską firmę Moonshot AI. Charakteryzuje się imponującym oknem kontekstowym wynoszącym 262,144 tokenów, co pozwala na analizę bardzo długich fragmentów kodu, dokumentacji, a nawet całych projektów. Model specjalizuje się w zadaniach związanych z kodowaniem, oferując:

– Bezpłatny dostęp (0,00 USD za 1 milion tokenów wejściowych i wyjściowych)

– Obsługę obrazów może analizować zrzuty ekranu, diagramy i schematy

– Ogromną pojemność kontekstową idealną do dużych projektów

– Wysoką jakość generowania kodu w różnych językach programowania

Porównanie z innymi modelami AI

Kimi K2.5 różni się od innych modeli AI w kilku kluczowych aspektach. Na przykład, w porównaniu do OpenAI GPT-4, który ma okno kontekstowe około 32,768 tokenów, Kimi K2.5 oferuje ponad 8x większą pojemność kontekstową, co jest kluczowe dla analizy projektów o skomplikowanej architekturze. W porównaniu do Anthropic Claude, który obsługuje obrazy tylko w ograniczonym zakresie, Kimi K2.5 ma pełną wsparcie dla obrazów funkcja, która może być niezwykle przydatna przy analizie diagramów architektonicznych lub debugowaniu błędów graficznych.

Dlaczego wersja K2.5?

Wersje modeli językowych często oznaczone są numerami wersji, które odnoszą się do stopnia zaawansowania i optymalizacji. W przypadku Kimi K2.5, numer „2.5” może oznaczać połączenie dwóch różnych modeli (np., K2 i K3), co zapewnia unikalną kombinację wiedzy technicznej i językowej. Takie podejście jest typowe dla firm prowadzących intensywnie testy modeli, jak Moonshot AI czy Anthropic.

Krok 1: Instalacja Visual Studio Code i pluginu Roo Code

Instalacja VS Code

Jeśli jeszcze nie masz Visual Studio Code, pobierz go z oficjalnej strony code.visualstudio.com. VS Code to darmowy, open-source’owy edytor, który stał się standardem w branży dzięki swojej lekkości, rozszerzalności i bogatej ekosystemie pluginów. Od momentu jego powstania (2015) VS Code przekształcił się z niszowego narzędzia na jedno z najpopularniejszych edytorów w świecie, z udziałem ponad 70% programistów globalnie.

Instalacja pluginu Roo Code

1. Otwórz VS Code.

2. Przejdź do zakładki Extensions (Ctrl+Shift+X).

3. Wyszukaj „Roo Code” lub „Roo Code”.

4. Kliknij Install na pierwszym wyniku.

5. Po instalacji, plugin będzie wymagał restartu VS Code.

Dlaczego Roo Code ?

Plugin Roo Code działa jako klient dla różnych modeli AI, w tym Kimi K2.5. Jego nazwa pochodzi od słowa „Roo Code”, które to skrót od „code line” referencyjne do linii kodu, na których pracuje plugin. Roo Code różni się od innych pluginów AI (np., GitHub Copilot) tym, że jest zbudowany jako wszechstronny klienckie narzędzie umożliwiające dostęp do wielu modeli AI, co pozwala programistom unikać zależności od jednej platformy.

Alternatywy dla Roo Code

W przypadku braku możliwości instalacji pluginu Roo Code, alternatywą może być Codeium inny plugin oferujący podobne funkcje (choć z innym modelem AI), lub Tabnine, który również integruje się z różnymi modelami. Jednak w przypadku Kimi K2.5 konieczna jest instalacja Roo Code, ponieważ nie ma bezpośredniego wdrożenia pluginu dla VS Code.

Krok 2: Konfiguracja dostępu do Kimi K2.5

Uzyskanie klucza API

1. Odwiedź stronę Kimi AI.

2. Zarejestruj konto (może wymagać chińskiego numeru telefonu rozważ użycie wirtualnego numeru).

3. Przejdź do sekcji API Keys w panelu developerskim.

4. Wygeneruj nowy klucz API.

5. Skopiuj klucz będziesz go potrzebować w następnym kroku.

Dlaczego wymagany jest chiński numer telefonu?

Wiele usług AI, szczególnie tych chińskich, ogranicza dostęp do użytkowników z Chińskiej Republiki Ludowej (PRC) lub wymaga potwierdzenia identyfikacji w ramach lokalnych regulaminów. Ta praktyka jest podobna do wcześniej stosowanych przez firmę Alibaba Cloud w przypadku modeli AI takich jak Qwen. Dla użytkowników poza Chinami istnieją jednak możliwości, takie jak użycie wirtualnego numeru telefonu lub zapisanie się na koncie w chińskiej sieci społecznościowej (np., WeChat).

Konfiguracja pluginu w VS Code

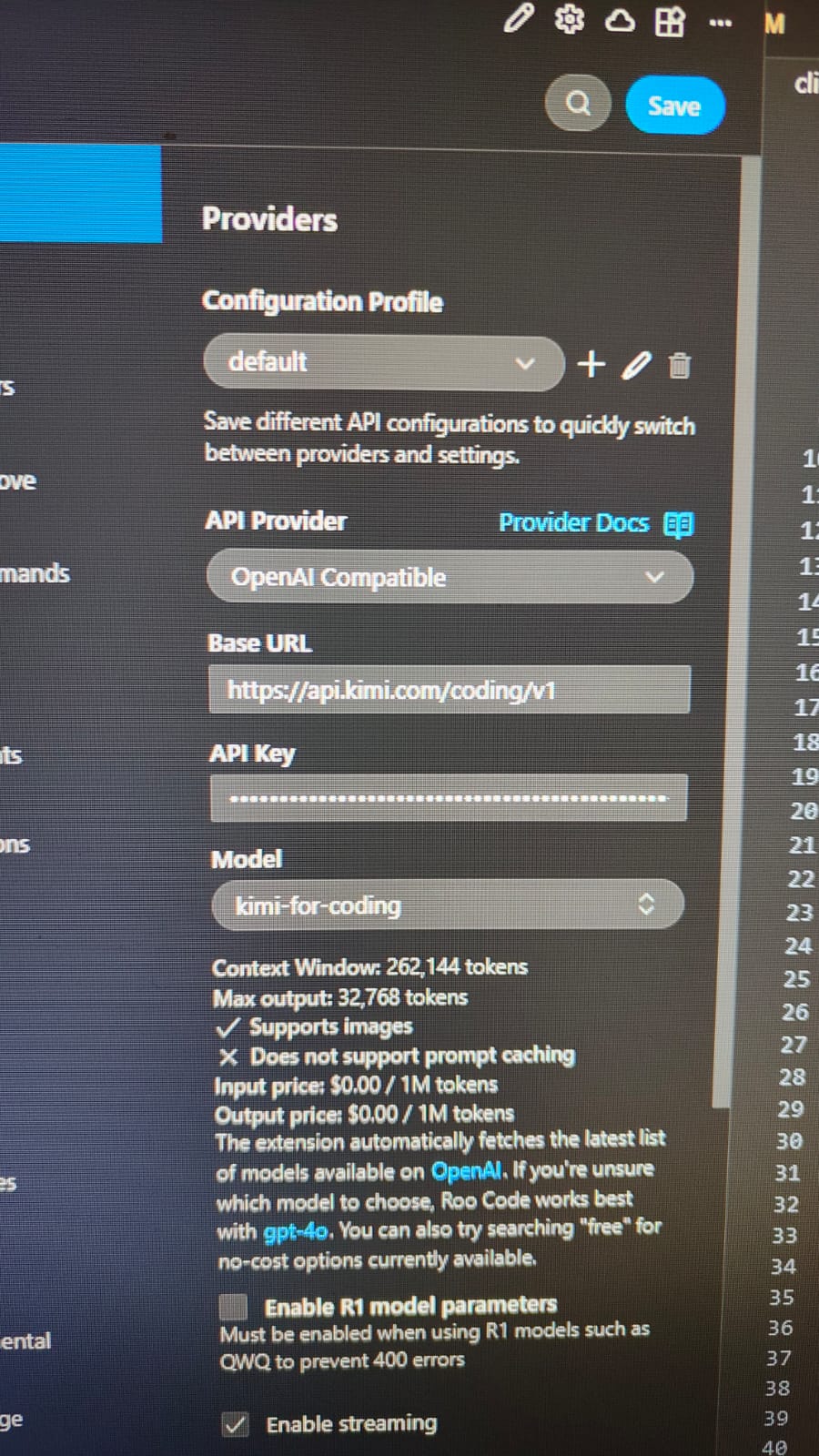

Oto dokładne parametry, które musisz ustawić (na podstawie zrzutu ekranu):

1. Configuration Profile: `default` (możesz tworzyć różne profile dla różnych projektów)

2. API Provider: `OpenAI Compatible`

3. Base URL: `https://api.kimi.com/coding/v1`

4. API Key: Wklej swój klucz API z Kimi

5. Model: `kimi-for-coding`

6. Enable streaming: ✓ (zalecane)

7. Enable R1 model parameters: ☐ (zostaw odznaczone, chyba że używasz modeli R1)

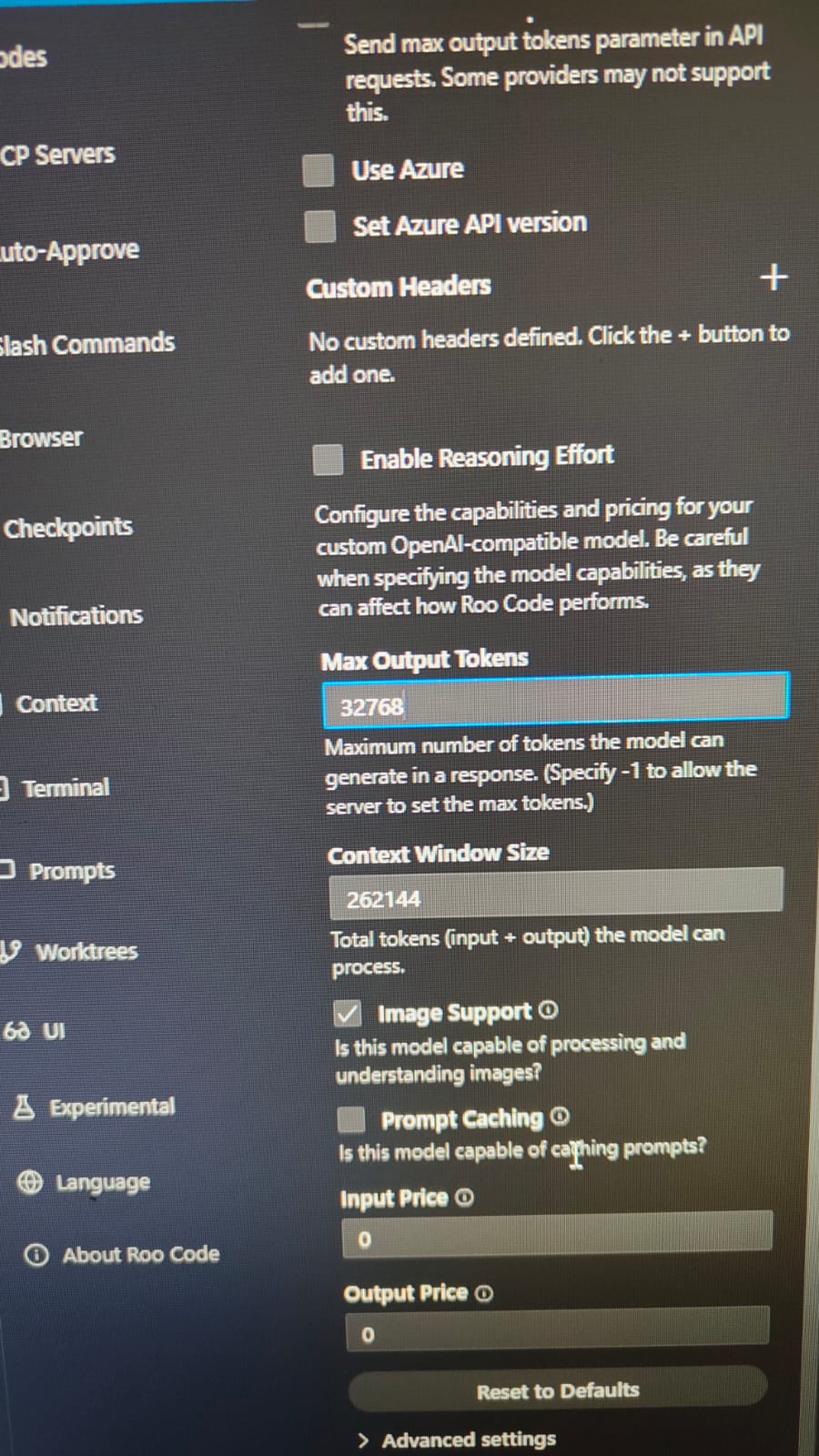

Szczegóły techniczne modelu:

– Context Window: 262,144 tokenów

– Max output: 32,768 tokenów

– Supports images: ✓

– Does not support prompt caching: ✗

– Input price: $0.00 / 1M tokens

– Output price: $0.00 / 1M tokens

Dlaczego brak prompt caching?

Brak możliwości cache’owania promptów (tekstów) może wpływać na wydajność modelu, szczególnie w przypadku powtarzających się pytań. Na przykład, jeśli programista zadałby kilka razy to samo pytanie o refaktoryzację kodu, każda kolejna odpowiedź wymusiłaby ponowne przetworzenie całego kontekstu, co może prowadzić do opóźnień. Dlatego warto monitorować użycie tokenów i unikać powtarzania tych samych pytań, jeśli to możliwe.

Krok 3: Testowanie konfiguracji

Prosty test funkcjonalności

1. Otwórz plik z kodem w VS Code.

2. Zaznacz fragment kodu.

3. Kliknij prawym przyciskiem myszy i wybierz opcję „Ask Roo Code” lub użyj skrótu klawiaturowego.

4. Zapytaj o wyjaśnienie, refaktoryzację lub optymalizację kodu.

5. Obserwuj, jak Kimi K2.5 generuje odpowiedź.

Przykład: Analiza wersji z biblioteką React

Pytanie: „Jak zoptymalizować komponent `App` w React?”.

Odpowiedź od Kimi K2.5:

– Zalecenie użycia `useMemo` do pamiętania obliczeń.

– Wskazówka dotycząca stosowania `React.lazy` i `Suspense`.

– Propozycja wdrożenia `shouldComponentUpdate` (w przypadku klasowych komponentów).

Zaawansowane funkcje:

– Analiza całych projektów: Dzięki ogromnemu oknu kontekstowemu, Kimi może analizować całe struktury projektów. Dla przykładu, jeśli programista chce przeanalizować architekturę aplikacji z wieloma pakietami i zależnościami, Kimi K2.5 może przeczytać cały kod, włącznie z `package.json`, `tsconfig.json` i plikami konfiguracyjnymi.

– Generowanie dokumentacji: Automatyczne tworzenie dokumentacji na podstawie kodu (np., generowanie Markdown lub dokumentacji API).

– Debugowanie: Sugestie naprawy błędów, takich jak `undefined variable` w TypeScriptie czy `null pointer` w Java.

– Konwersja między językami: Tłumaczenie kodu z Pythona do JavaScriptu (np., konwersja pętli `for` na `map`).

Krok 4: Best practices i optymalizacja

Optymalne wykorzystanie okna kontekstowego

1. Grupowanie pytań: Zamiast wielu małych pytań, przygotuj jedno kompleksowe. Na przykład, zamiast zapytywać „Jak zoptymalizować funkcję A?”, „Jak zoptymalizować funkcję B?” i „Jak zoptymalizować funkcję C?”, lepiej zadawać pytanie: „Jak zoptymalizować funkcje A, B i C w projekcie X?”.

2. Dostarczanie kontekstu: Dołącz relevantne fragmenty kodu, błędy kompilacji, lub wymagania. Na przykład, jeśli Kimi K2.5 ma analizować bug w aplikacji React, warto dołączyć cały plik `App.js` oraz dane błędów z konsoli deweloperskiej.

3. Strukturyzacja: Używaj komentarzy i oznaczeń, aby pomóc modelowi zrozumieć strukturę projektu (np., oznaczanie funkcji jako `// funkcja: przekształca dane` lub `// moduł: obsługa API`).

Zarządzanie kosztami

Mimo że Kimi K2.5 jest obecnie darmowy, warto monitorować użycie:

1. Limit tokenów: 262K tokenów na request to dużo, ale nie nieskończoność. Dla przykładu, jeśli użytkownik zapyta o analizę całego projektu (np., aplikacja z ponad 50 plikami kodu), może zużyć ok. 100k tokenów.

2. Efektywne prompty: Precyzyjne pytania dają lepsze odpowiedzi. Na przykład, zamiast pisać „Zrób coś z tym kodem”, lepiej napisać „Refaktoryzuj funkcję `handleLogin` w aplikacji React tak, by był bardziej testowalny i optymalny pod kątem wydajności”.

3. Cache’owanie: Model nie wspiera prompt caching, więc powtarzające się zapytania będą zużywać tokeny. Można to obejść przez zapamiętywanie odpowiedzi w lokalnym pliku (np., `notes.md`) lub używając systemu notatek w VS Code.

Krok 5: Rozwiązywanie problemów

Typowe problemy i rozwiązania:

Problem: „Invalid API Key”

– Rozwiązanie: Sprawdź, czy klucz został poprawnie skopiowany, bez dodatkowych spacji. Przejrzyj również ustawienia w konfiguracji Roo Code czasem może być błąd w polu `API Key`. Jeśli problem trwa, spróbuj ponownie wygenerować klucz na stronie Kimi AI i zresetować tokeny.

Problem: „Connection timeout”

– Rozwiązanie: Sprawdź połączenie internetowe (np., uruchom `ping api.kimi.com` w terminalu). Upewnij się, że konto Kimi nie zostało wstrzymane z powodu nadmiernej aktywności. Jeśli problem dotyczy tylko jednego komputera, może to być spowodowane firewall’em lub oprogramowaniem antywirusowym.

Problem: „Model not available”

– Rozwiązanie: Upewnij się, że wybrałeś `kimi-for-coding` jako model. Sprawdź również status API na stronie Kimi AI czasem modele są w trybie testowania lub przerywane z powodu aktualizacji (np., 2024 roczna aktualizacja).

Problem: „Response too slow”

– Rozwiązanie: Włącz streaming dla lepszego doświadczenia. Jeśli odpowiedź nadal jest zbyt wolna, rozważ zmniejszenie długości promptu lub użycie modelu o mniejszej pojemności kontekstowej (np., `kimi-for-coding-mini`).

Przyszłość Kimi K2.5 i programowania wspomaganego AI

Trendy i prognozy

Integracja modeli AI jak Kimi K2.5 z edytorami kodu to dopiero początek rewolucji. W ciągu najbliższych lat możemy spodziewać się:

1. Głębszej integracji: Modele staną się nierozerwalną częścią środowisk developerskich, a nie tylko narzędziami pośrednimi (np., integracja AI w IDE takich jak IntelliJ IDEA lub Eclipse).

2. Specjalizowanych modeli: Powstaną modele dedykowane konkretnym językom, frameworkom, lub nawet dziedzinom (np., AI dla embedded systems, game dev, etc.).

3. Kolaboracji w czasie rzeczywistym: Wielu programistów współpracujących z tym samym modelem na jednym projekcie (np., AI jako „co-pilot” w projektach zespołów).

4. Automatyzacji testów i deploymentu: AI nie tylko będzie pisać kod, ale także testować i wdrażać rozwiązania (np., generowanie testów unitowych na podstawie dokumentacji).

Wyzwania etyczne i zawodowe

– Zależność od AI: Jak zachować umiejętności programistyczne w erze automatyzacji? Programiści będą musieli rozwijać umiejętności analizy, krytycznego myślenia i architektury oprogramowania.

– Bezpieczeństwo: Modele mogą generować podatny kod lub sugerować niebezpieczne rozwiązania (np., kod z wadami bezpieczeństwa). Programiści będą musieli rozwijać umiejętności oceny jakości AI, a firmy tworzyć polityki kontroli generowanego kodu.

– Regulacje: Kraje mogą wprowadzać ograniczenia w użyciu zagranicznych modeli AI. Przykładem może być przepis EU AI Act, który w 2025 roku będzie wymagał dopuszczalności modeli do użytku w Unii Europejskiej, co może wpływać na dostępność Kimi K2.5 dla użytkowników z Europy.

Przykłady historyczne:

– GitHub Copilot (2018): Pionierska integracja AI w edytorach kodu. Choć oferował sugestie kodu, nie miał wsparcia dla obrazów ani tak ogromnego okna kontekstowego jak Kimi K2.5.

– Alibaba Qwen (2023): Model z chińskiego środowiska, który oferuje podobne funkcje AI w programowaniu. Jednak różni się od Kimi K2.5 brakiem wsparcia dla obrazów i mniejszą pojemnością kontekstową.

– Anthropic Claude (2023): Modele z USA, które są bardziej zaawansowane pod względem logiki językowej, ale mniej zaawansowane pod względem analizy kodu niż Kimi K2.5.

Podsumowanie

Konfiguracja Kimi K2.5 w Visual Studio Code z pluginem Roo Code to stosunkowo prosty proces, który otwiera drzwi do potężnych możliwości. Dzięki imponującemu oknu kontekstowemu (262K tokenów), wsparciu dla obrazów i darmowemu dostępowi (przynajmniej na razie), Kimi K2.5 stanowi atrakcyjną alternatywę dla innych modeli AI.

Kluczowe korzyści:

– ✅ Ogromne okno kontekstowe (262K tokenów)

– ✅ Obsługa obrazów

– ✅ Darmowy dostęp

– ✅ Wysoka jakość generowania kodu

– ✅ Integracja z popularnym edytorem VS Code

Potencjalne wyzwania:

– ❌ Może wymagać chińskiej rejestracji

– ❌ Brak prompt caching

– ❌ Niepewność co do długoterminowej dostępności darmowego tieru

Niezależnie od wyzwań, integracja AI z procesem programowania jest nieunikniona. Kimi K2.5 z VS Code i Roo Code to doskonały punkt startowy do eksploracji tej nowej granicy w rozwoju oprogramowania.